EDIF : Fusion d'Images Multi-Modales et Multi-Vues Guidée par la Détection

📄 Article scientifique associé : EDIF: End-to-end Detection-driven Image Fusion

🎯 Introduction : Le défi de la perception multi-capteurs

La fusion d'images est au cœur de nombreux systèmes de vision par ordinateur modernes, de l'imagerie médicale à la conduite autonome en passant par la surveillance. En combinant des informations complémentaires provenant de sources hétérogènes, elle améliore la fiabilité de la perception dans des conditions difficiles : occlusions, faible luminosité, dégradation des capteurs.

Cependant, la plupart des approches existantes restent spécialisées :

- Fusion multi-modale : intègre des indices spectraux ou spécifiques aux capteurs (RGB + thermique, visible + infrarouge)

- Fusion multi-vue : assure la cohérence géométrique entre plusieurs caméras

Bien qu'efficaces dans leurs domaines respectifs, ces paradigmes sont généralement développés isolément et ne sont pas conçus pour généraliser entre les catégories de fusion. Pourtant, de nombreux systèmes de perception du monde réel combinent intrinsèquement les deux dimensions : imagerie médicale multi-modale multi-vue, plateformes de conduite autonome intégrant plusieurs capteurs et points de vue.

❓ Le défi : Unifier multi-modal et multi-vue

Concevoir un framework unifié qui gère à la fois la fusion multi-modale et multi-vue pose plusieurs défis :

🔴 Hétérogénéité des données

🔴 Data Heterogeneity

🔴 データの異質性

Les images provenant de différents capteurs (RGB, thermique, NIR, polarisation) ont des caractéristiques spectrales très différentes. Comment les représenter dans un espace commun ?

🔴 Alignement géométrique

🔴 Geometric Alignment

🔴 幾何学的アライメント

Les images multi-vues capturent la même scène sous différents angles. Comment apparier les objets correspondants malgré les changements de perspective ?

🔴 Optimisation pour la tâche finale

🔴 Optimization for the Final Task

🔴 最終タスクのための最適化

La plupart des méthodes de fusion sont conçues indépendamment de la tâche finale (détection, segmentation...). Comment optimiser la fusion directement pour améliorer la détection d'objets ?

💡 L'intuition clé d'EDIF :

Plutôt que de fusionner au niveau des pixels (comme les méthodes traditionnelles), EDIF formule la fusion comme un problème d'alignement au niveau des objets. Les images hétérogènes sont encodées comme des ensembles de keypoints (points clés), puis appariées et agrégées via un mécanisme d'attention graphique.

💡 La solution EDIF : Architecture et méthode

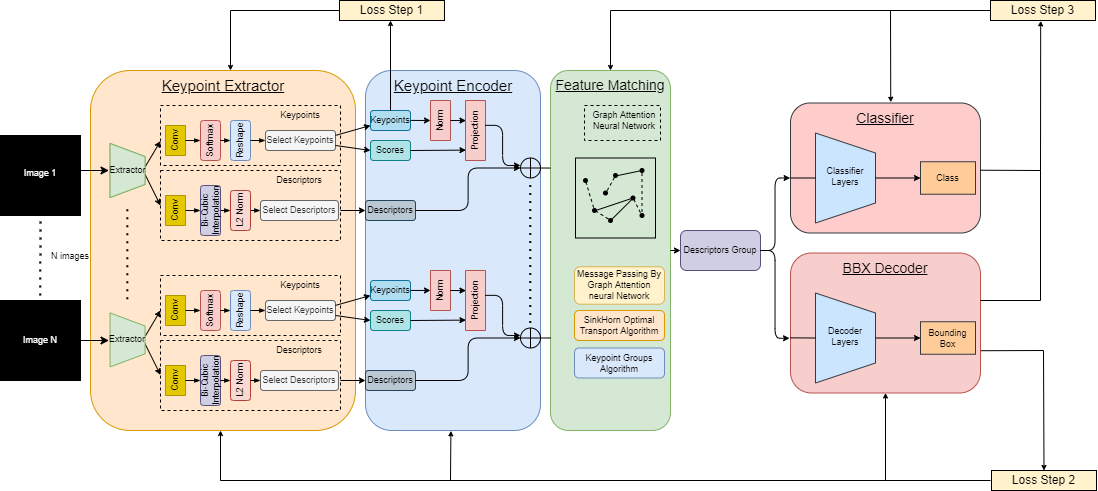

EDIF (End-to-end Detection-driven Image Fusion) propose une architecture unifiée qui traite la fusion comme un problème d'alignement au niveau des objets. Le framework se compose de trois modules principaux :

Figure : Architecture complète d'EDIF montrant les trois modules principaux : TransPoint (extraction de keypoints), GANN (matching et grouping), et le décodeur avec tête de détection.

🔧 Module 1 : TransPoint - Extracteur de keypoints

🔧 Module 1: TransPoint - Keypoint Extractor

🔧 モジュール1:TransPoint - キーポイント抽出器

Le module TransPoint transforme chaque image d'entrée (quelle que soit sa modalité) en un ensemble de keypoints. Chaque keypoint est caractérisé par :

- Position : coordonnées (x, y) dans l'image

- Descripteur : vecteur de caractéristiques qui encode l'apparence locale

- Score de confiance : probabilité que ce keypoint corresponde à un objet réel

🎯 Pourquoi des keypoints ?

Les keypoints offrent une représentation compacte et invariante qui facilite l'appariement entre images hétérogènes. Contrairement aux pixels bruts, les keypoints capturent directement les structures sémantiques (objets) plutôt que les détails de bas niveau.

🔧 Module 2 : GANN - Graph Attention pour le matching

🔧 Module 2: GANN - Graph Attention for Matching

🔧 モジュール2:GANN - マッチングのためのグラフアテンション

Le module GANN (Graph Attention Neural Network) est le cœur de la fusion. Il prend en entrée les ensembles de keypoints de toutes les images et effectue :

1️⃣ Matching (appariement)

Pour chaque keypoint, le GANN calcule des scores d'attention avec tous les keypoints des autres images. Cela permet d'identifier quels keypoints correspondent au même objet.

2️⃣ Grouping (regroupement)

Les keypoints appariés sont regroupés pour former des représentations fusionnées qui agrègent l'information de toutes les modalités et vues.

🔧 Module 3 : Décodeur et tête de détection

🔧 Module 3: Decoder and Detection Head

🔧 モジュール3:デコーダーと検出ヘッド

Les keypoints fusionnés sont passés à un décodeur qui prédit directement les boîtes englobantes (bounding boxes) et les classes d'objets. Tout le pipeline est end-to-end différentiable, ce qui permet d'optimiser conjointement l'extraction de keypoints, le matching et la détection.

🎓 Stratégie d'apprentissage en trois étapes

Pour entraîner efficacement EDIF, nous utilisons une stratégie d'apprentissage progressif en trois étapes qui aligne progressivement l'extraction de keypoints, la localisation d'objets et le regroupement cross-capteurs :

Étape 1 : Pré-entraînement des keypoints

Stage 1: Keypoint Pretraining

ステージ1:キーポイント事前トレーニング

Objectif : Apprendre à extraire des keypoints cohérents entre différentes modalités.

Méthode : Utilisation d'une perte de cohérence des descripteurs (descriptor consistency loss) pour s'assurer que les keypoints correspondant au même objet dans différentes images ont des descripteurs similaires.

Étape 2 : Localisation d'objets

Stage 2: Object Localization

ステージ2:オブジェクトローカリゼーション

Objectif : Apprendre à estimer la confiance que chaque keypoint corresponde à un objet réel.

Méthode : Entraînement avec des annotations de boîtes englobantes pour affiner les scores de confiance des keypoints.

Étape 3 : Détection et regroupement cross-capteurs

Stage 3: Detection and Cross-Sensor Grouping

ステージ3:検出とクロスセンサーグループ化

Objectif : Optimiser conjointement le matching, la fusion et la détection finale.

Méthode : Entraînement end-to-end de tout le pipeline avec la perte de détection (classification + régression des boîtes englobantes).

💡 Pourquoi trois étapes ?

Cette approche progressive permet au modèle d'apprendre des représentations de plus en plus complexes : d'abord l'alignement de base entre modalités, puis la localisation d'objets, et enfin la fusion complète pour la détection. Cela évite les problèmes de convergence qui surviendraient avec un entraînement direct end-to-end.

🛢️ Le dataset MMDOD : Un benchmark pour tester EDIF

Pour évaluer EDIF, nous avons créé le Multi-Modal and Multi-View Object Detection Dataset (MMDOD), un dataset unique qui combine :

📊 Statistiques

- • 10,000+ images

- • 21,469 annotations

- • 8 classes d'objets

🎥 4 Modalités

- • Visible (RGB)

- • Proche infrarouge (NIR)

- • Faible contraste

- • Décalage de polarisation

📹 6 Points de vue

- • Caméras synchronisées

- • Angles variés

- • Calibration précise

- • Annotations alignées

🌟 Pourquoi MMDOD est unique ?

MMDOD est le premier dataset qui combine simultanément plusieurs modalités ET plusieurs vues. Cela permet d'évaluer des méthodes de fusion dans des scénarios réalistes où les deux dimensions sont présentes, comme dans les systèmes de surveillance industrielle ou les véhicules autonomes.

📈 Résultats expérimentaux : Performances d'EDIF

EDIF a été évalué sur plusieurs benchmarks standards pour démontrer sa capacité à gérer la fusion multi-modale, multi-vue, et la combinaison des deux. Les résultats montrent qu'EDIF atteint des performances compétitives avec les méthodes spécialisées tout en étant le seul framework unifié.

🔥 Fusion multi-modale (RGB + Thermique)

🔥 Multi-Modal Fusion (RGB + Thermal)

🔥 マルチモーダル融合(RGB +サーマル)

Résultats sur les benchmarks M3FD et FLIR (détection RGB-thermique) :

| Méthode | mAP@50 | mAP@75 |

|---|---|---|

| TarDAL | 75.8 | 36.2 |

| SeAFusion | 77.1 | 37.4 |

| EDIF (ours) | 76.3 | 36.8 |

📹 Fusion multi-vue

📹 Multi-View Fusion

📹 マルチビュー融合

Résultats sur les benchmarks Wildtrack et MultiViewX (détection multi-caméra) :

| Méthode | MODA ↑ | MODP ↑ | Prec. ↑ | Rec. ↑ |

|---|---|---|---|---|

| MVDet | 88.2 | 75.7 | 94.7 | 93.6 |

| SHOT | 90.2 | 76.5 | 96.9 | 93.3 |

| EDIF (ours) | 89.4 | 76.1 | 95.3 | 94.1 |

🌟 Fusion multi-modale ET multi-vue (MMDOD)

🌟 Multi-Modal AND Multi-View Fusion (MMDOD)

🌟 マルチモーダルとマルチビュー融合(MMDOD)

Résultats sur le benchmark MMDOD (le seul qui combine les deux dimensions) :

| Méthode | mAP@50 | mAP@75 |

|---|---|---|

| MVMM-DET | 64.9 | 29.2 |

| EDIF (ours) | 79.7 | 38.5 |

✅ Ce que montrent ces résultats :

- EDIF est compétitif avec les méthodes spécialisées sur les benchmarks multi-modaux et multi-vues

- EDIF surpasse largement (+14.8 mAP@50) les méthodes existantes sur MMDOD, le seul benchmark combinant les deux dimensions

- EDIF est le seul framework unifié capable de gérer tous ces scénarios avec une seule architecture

📖 Quelques références scientifiques

Voici quelques travaux clés qui ont inspiré ou sont liés à EDIF :

TarDAL - Liu et al., "Target-aware Dual Adversarial Learning and a Multi-scenario Multi-Modality Benchmark to Fuse Infrared and Visible for Object Detection", CVPR 2022

🔗 CVPR 2022

SeAFusion - Tang et al., "Image fusion in the loop of high-level vision tasks: A semantic-aware real-time infrared and visible image fusion network", Information Fusion 2022

🔗 ScienceDirect

MVDet - Hou et al., "Multiview Detection with Feature Perspective Transformation", ECCV 2020

🔗 ECCV 2020

🎓 Conclusion

EDIF représente une avancée importante dans le domaine de la fusion d'images pour la détection d'objets. En unifiant la fusion multi-modale et multi-vue dans un seul framework end-to-end, EDIF ouvre la voie à des systèmes de perception plus robustes et plus complets pour les applications industrielles et robotiques.