MMDOD - Multi-Modal and Multi-View Object Detection Dataset

Le premier benchmark dédié à la fusion d'images multi-modale et multi-vue pour la détection d'objets

🖼️ Aperçu du Dataset

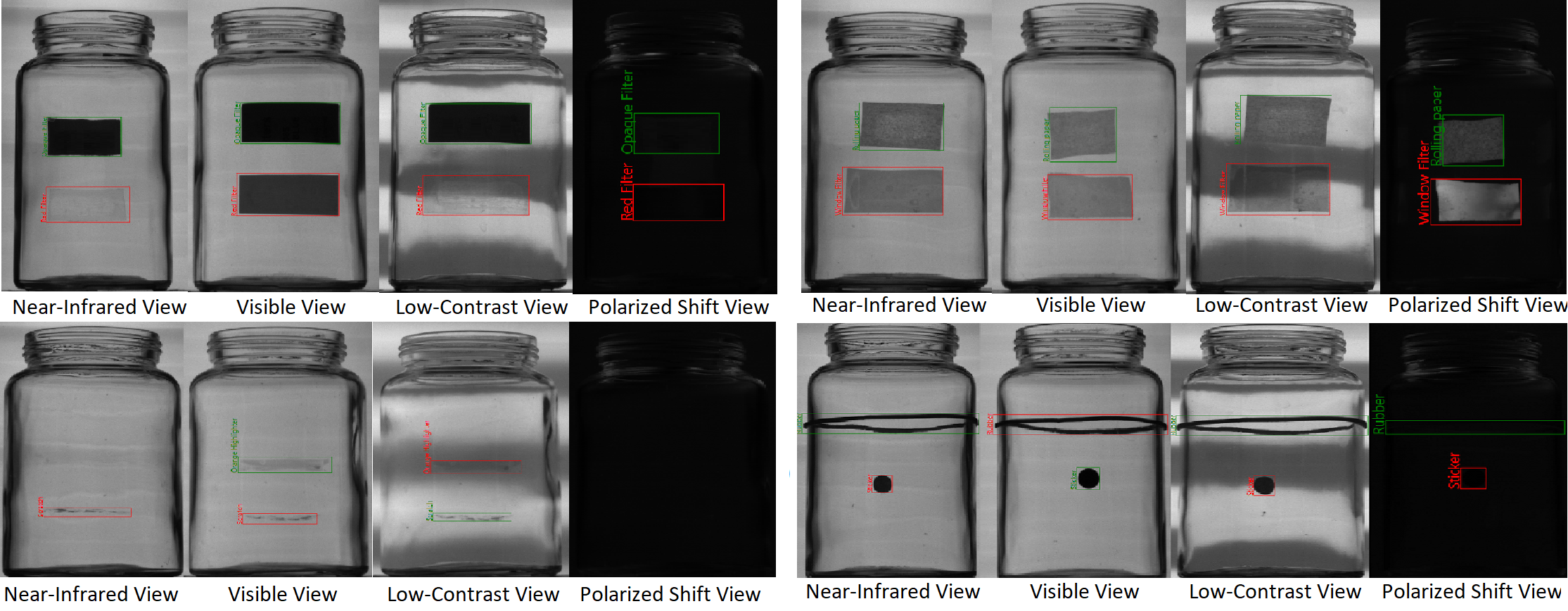

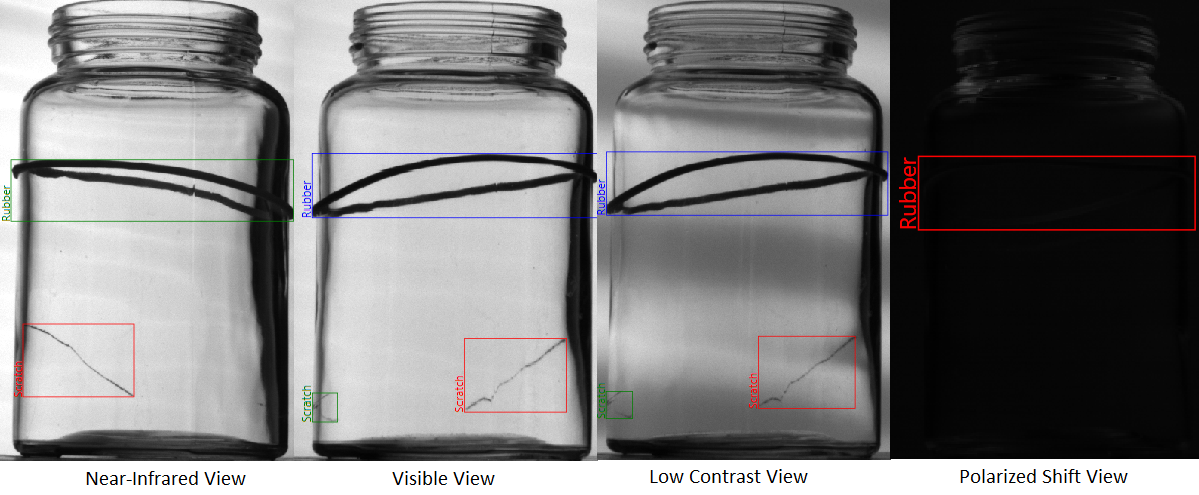

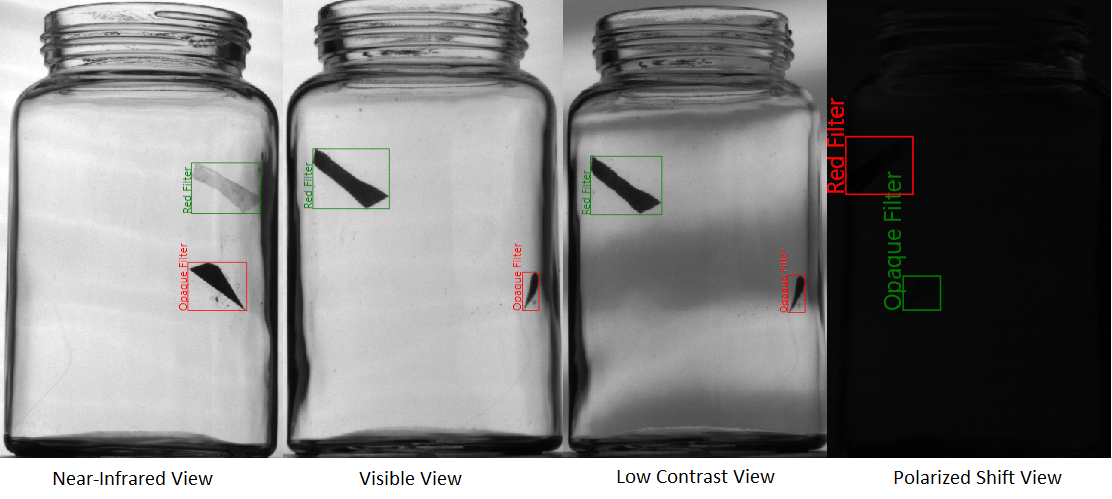

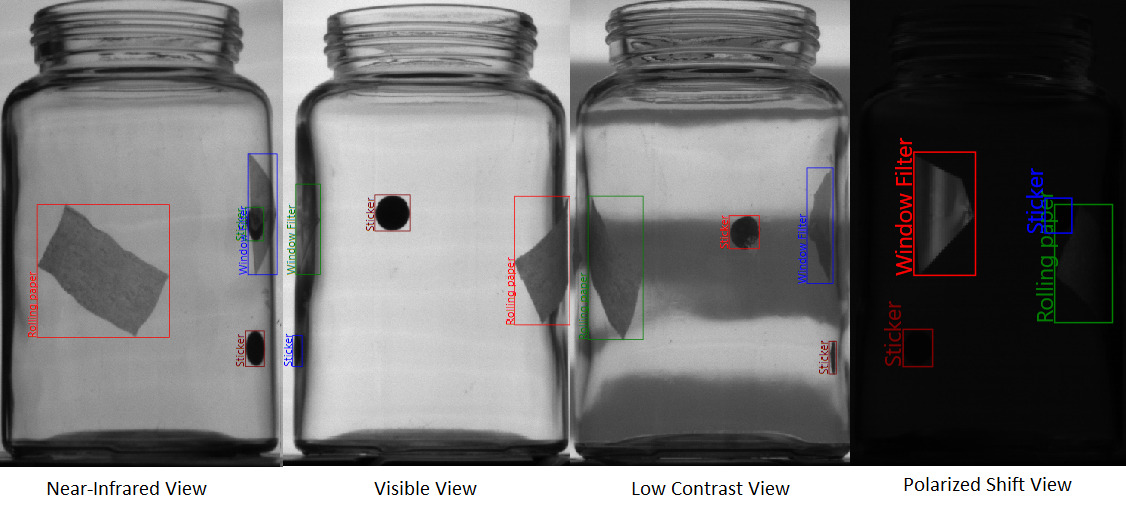

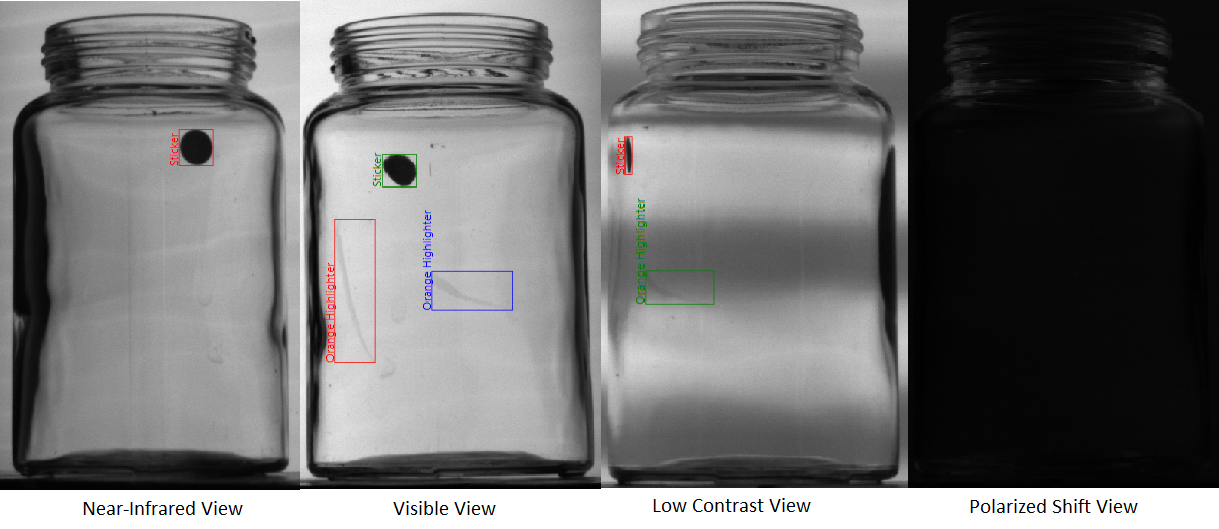

Exemples de défauts et objets à travers les différentes modalités d'imagerie

📖 Introduction

Contexte : Le dataset MMDOD a été créé pour répondre au besoin croissant de benchmarks

dédiés à la fusion d'images multi-modale et multi-vue dans le contexte de la détection d'objets.

Motivation : Les méthodes traditionnelles de détection d'objets peinent à gérer

les matériaux transparents et les conditions d'éclairage complexes. MMDOD propose une solution

en combinant plusieurs modalités d'imagerie et points de vue pour améliorer la robustesse de la détection.

Applications : Ce dataset est particulièrement adapté pour l'inspection industrielle

de conteneurs en verre, la détection de défauts, et le développement de systèmes de vision multi-capteurs.

🔬 Setup Expérimental

Configuration des caméras : Pour générer un dataset multi-modal et multi-vue pour la détection d'objets sur des conteneurs en verre transportés par un convoyeur, un système d'acquisition d'images à double station a été utilisé, chaque station étant composée de six caméras haute fréquence (3 GHz) équipées de capteurs CMOS monochromes. Ces capteurs ne disposent pas de filtres de Bayer et fournissent donc des images en niveaux de gris 10 bits qui sont encodées en profondeur 8 bits à l'aide de protocoles de communication standard.

Les deux stations d'acquisition d'images sont positionnées séquentiellement le long du convoyeur en raison de contraintes spatiales, chaque station capturant trois vues angulaires à l'aide de paires de caméras (une avec un filtre polarimétrique et une sans). Les caméras sont montées le long de six axes optiques dans le plan horizontal, répartis symétriquement sur les deux stations. La séparation angulaire entre les caméras du même type est de 50°, tandis que l'axe optique de chaque caméra est orienté à 40° par rapport à l'axe du convoyeur. Chaque axe optique comprend deux caméras légèrement décalées (±2°) pour accueillir les modalités polarimétriques et non polarimétriques, tout en maintenant une séparation angulaire cohérente entre chaque axe de visualisation.

En termes de positionnement vertical, chaque axe de visualisation est équipé de deux caméras : une caméra "corps" placée dans une configuration à angle bas pour imager la partie inférieure de l'article sans capturer le convoyeur, et une caméra "épaule" placée plus haut, inclinée à des angles variables (-30°). Cette configuration soigneusement calibrée permet une couverture visuelle dense des objets en verre transparents et réfléchissants sous plusieurs points de vue et sous diverses conditions d'éclairage et de polarisation.

Système d'éclairage : La première station fonctionne avec une source de lumière structurée proche infrarouge de 820 nm, qui est non polarisée et conçue pour mettre en évidence les caractéristiques à faible contraste en contrôlant les bandes de lumière éclairées, particulièrement pour la détection d'objets au niveau de la surface (modalité faible contraste). La deuxième station est éclairée par une source de lumière visible polarisée, pilotée par un contrôleur qui permet l'activation sélective des bandes. Cette source émet une lumière linéairement polarisée utilisée en conjonction avec des filtres polarisants montés sur la moitié des caméras pour permettre l'imagerie polarimétrique, cruciale pour le décalage de polarisation en analysant les effets de biréfringence dans le matériau de verre, tandis que les autres caméras capturent des images dans la gamme visible pour l'inspection générale.

Objet en verre : L'objet en verre utilisé tout au long de l'acquisition du dataset est un pot cylindrique mesurant 62 mm de diamètre et 105 mm de hauteur, avec un diamètre de col de 50 mm. Cette géométrie standardisée assure une couverture cohérente à travers toutes les modalités d'imagerie tout en maintenant la compatibilité mécanique avec le setup d'acquisition.

🎨 Modalités d'Imagerie

Le système d'acquisition d'images fournit quatre modalités d'imagerie complémentaires : Décalage de Polarisation, Proche Infrarouge, Visible et Faible Contraste. Chacune est conçue pour capturer des caractéristiques physiques distinctes des conteneurs en verre, améliorant ainsi l'efficacité de la détection d'objets. Ensemble, ces quatre modalités offrent une représentation multi-modale complète de chaque conteneur en verre, capturant à la fois des phénomènes de surface et de subsurface à travers divers domaines optiques et spectraux.

1. Décalage de Polarisation

Les vues de décalage de polarisation reposent sur la dépolarisation de la lumière linéairement polarisée causée par les contraintes mécaniques internes ou les inclusions dans le matériau de verre. Ces images sont acquises en associant une source de lumière visible polarisée avec des caméras équipées de filtres de polarisation. Jusqu'à trois vues de décalage de polarisation sont acquises par conteneur à partir de caméras au niveau du corps.

2. Proche Infrarouge (NIR)

Les vues proche infrarouge fonctionnent dans un domaine spectral distinct et sont précieuses pour détecter les anomalies de surface ou les variations de matériau internes qui ne sont pas perceptibles dans le spectre visible. Un total de douze vues NIR sont capturées : six vues (trois corps et trois épaules) acquises sous illumination proche infrarouge standard, et six vues supplémentaires capturées sous la même source lumineuse configurée en mode structuré pour l'imagerie à faible contraste.

3. Lumière Visible

Les vues visibles, obtenues en utilisant une lumière visible non polarisée et des caméras sans filtres de polarisation, servent de modalité principale pour l'évaluation visuelle. Ces images fournissent des informations structurelles détaillées sur les conteneurs en verre, y compris leur forme, leurs contours et leurs caractéristiques de surface. Un total de douze vues visibles sont acquises : six vues sous illumination visible uniforme (trois corps et trois épaules), et six vues supplémentaires capturées en utilisant le motif de lumière structurée utilisé pour l'imagerie à faible contraste.

4. Faible Contraste

Les vues à faible contraste sont des images en niveaux de gris capturées à l'aide d'une source d'illumination structurée composée de bandes éclairées et non éclairées configurables. Cette technique d'éclairage améliore la visibilité des variations géométriques subtiles et des caractéristiques de surface, telles que les changements d'épaisseur du verre ou les objets de texture mineurs, qui ne sont pas facilement visibles dans des conditions d'éclairage standard.

🔍 Classes d'Objets et Détectabilité

Le tableau ci-dessous présente la détectabilité qualitative des différentes classes d'objets à travers les modalités d'imagerie. Les termes Obvious (évident), Unseen (invisible), Unclear (ambigu) et Depends (dépend) décrivent si un objet est clairement visible, invisible, détectable de manière ambiguë ou détectable conditionnellement, respectivement.

| Classe d'Objet / Modalité | NIR | Visible | NIR Faible Contraste | Visible Faible Contraste | Décalage de Polarisation |

|---|---|---|---|---|---|

| Sticker | Obvious | Obvious | Obvious | Obvious | Depends |

| Rubber | Obvious | Obvious | Obvious | Obvious | Depends |

| Orange Highlighter | Unseen | Obvious | Unseen | Depends | Unseen |

| Opaque Filter | Obvious | Unclear | Obvious | Unclear | Depends |

| Red Filter | Obvious | Unclear | Obvious | Unclear | Depends |

| Rolling Paper | Unclear | Unclear | Unclear | Unclear | Obvious |

| Window Filter | Unclear | Unclear | Unclear | Unclear | Obvious |

| Scratch | Obvious | Obvious | Depends | Depends | Unseen |

Les cellules surlignées en rouge indiquent une visibilité incohérente entre les modalités (par exemple, les filtres en proche infrarouge vs visible), tandis que les cellules surlignées en orange désignent les cas où la visibilité n'est révélée que par l'imagerie par décalage de polarisation.

Exemples de Défauts

Rubber & Scratch - Toutes modalités

Opaque Filter & Red Filter - Toutes modalités

Red Filter & Rolling Paper - Toutes modalités

Orange Highlighter & Sticker - Toutes modalités

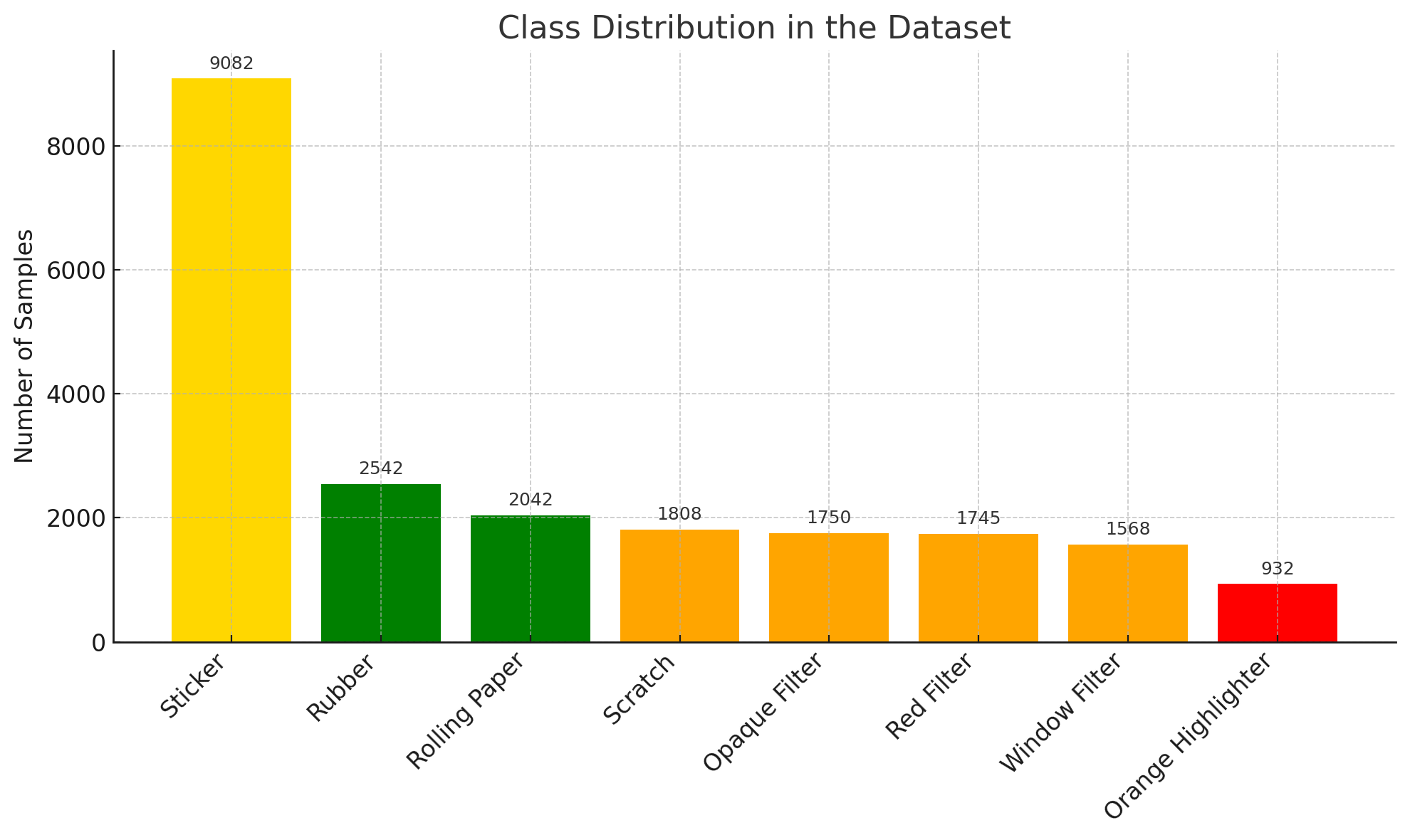

🏷️ Classes et Annotations

Le dataset MMDOD contient des annotations détaillées pour plusieurs types de défauts et artefacts. Chaque objet est annoté avec des bounding boxes et des labels de classe.

🔴 Objets Destructifs

- Scratch (Rayure) - 1,808 échantillons

🟡 Objets Non-Destructifs

- Sticker (Autocollant) - 9,082 échantillons

- Rubber (Élastique) - 2,542 échantillons

- Rolling Paper (Papier à rouler) - 2,042 échantillons

- Opaque Filter (Filtre opaque) - 1,750 échantillons

- Red Filter (Filtre rouge) - 1,745 échantillons

- Window Filter (Filtre fenêtre UV) - 1,568 échantillons

- Orange Highlighter (Surligneur orange) - 932 échantillons

📋 Format d'Annotation

Les annotations sont fournies sous forme de fichiers texte (un fichier .txt par image) avec le même nom que l'image correspondante. Chaque ligne du fichier représente une annotation au format :

Class;center_x;center_y;width;height

Exemple :

Sticker;256.3932;301.3744;53.9775;28.4881 Sticker;290.8788;290.8788;54.7272;35.2353 Rubber;71.2203;253.6443;91.212;372.3449

Structure des répertoires :

-

train/: 284 scènes (80%) -

test/: 71 scènes (20%) -

empty/: 20 scènes sans défauts

Convention de nommage des images :

Format : timestamp_modalité_vue_caméra.jpg

Exemple : 20250721112718414_26_10_E.jpg

Codes de modalités :

-

26: Visible et Infrarouge (vues 1-6 = NIR, vues 7-12 = Visible) -

28: Faible Contraste -

66: Décalage de Polarisation (Stress)

Angles de caméra :

-

C: Caméra de face -

E: Caméra en plongée

📊 Statistiques du Dataset

📈 Distribution des Classes

📋 Répartition Train/Test

| Ensemble | Scènes | Images | Description |

|---|---|---|---|

| Train | 284 | 7,668 | Ensemble d'entraînement |

| Test | 71 | 1,917 | Ensemble de test |

| Empty | 20 | 540 | Scènes sans défauts |

| Total | 375 | 10,125 | - |

📝 Citation

Si vous utilisez ce dataset dans vos travaux de recherche, veuillez citer la publication suivante :

@misc{bernardi2026edif,

title={End-To-End Multi-View Multi-Modal Detection-Driven Image Fusion: One Method to Fuse them all},

author={Bernardi, Gwendal and Brisebarre, Godefroy and Roman, Sébastien and Ardabilian, Mohsen and Dellendrea, Emmanuel},

year={2026},

note={hal-05493938}

}

⚖️ Licence

Ce dataset est mis à disposition sous licence Creative Commons Attribution 4.0 International (CC BY 4.0). Vous êtes libre de partager et adapter le dataset pour tout usage, y compris commercial, à condition de créditer les auteurs.